Dans la leçon précédente, nous avons découvert les grandes familles de l’IA : symbolique, apprentissage automatique, deep learning. L’une des questions qui fascine, inquiète ou suscite la curiosité, c’est celle-ci : mais comment une intelligence artificielle « apprend-elle » vraiment ?

C’est une question essentielle si l’on veut comprendre les promesses et les limites de ces outils. Car à la différence d’un programme classique, une IA moderne ne se contente pas d’exécuter des instructions : elle génère des modèles à partir des données qu’elle analyse.

- Dans cet article

- Les trois grandes formes d'apprentissage automatique

- Ce que “apprendre” veut dire pour une machine (et ce que ça ne veut pas dire)

- Ce que cela change pour l’innovation en entreprise

- Ce que vous pouvez faire concrètement pour progresser

- À retenir

- Testez vos connaissances

- Partager avec les autres innovateurs

- Ressources

Mais que signifie « apprendre » pour une machine ? Peut-elle le faire seule ? Que faut-il lui fournir ? Est-ce qu’elle apprend bien ? Et surtout : comment s’assurer qu’elle n’apprend pas n’importe quoi ?

Cette troisième leçon propose de répondre à ces questions en explorant les différents types d’apprentissage, les méthodes utilisées, les conditions de réussite… et les nombreuses embûches qui guettent les projets IA mal encadrés.

Les trois grandes formes d’apprentissage automatique

L’apprentissage supervisé : apprendre avec des exemples

Dans cette configuration, on fournit à la machine une série d’exemples déjà résolus : chaque donnée d’entrée est associée à une réponse correcte. Le but est que l’IA apprenne à généraliser cette connaissance pour pouvoir prédire la bonne réponse lorsqu’on lui présentera un nouveau cas.

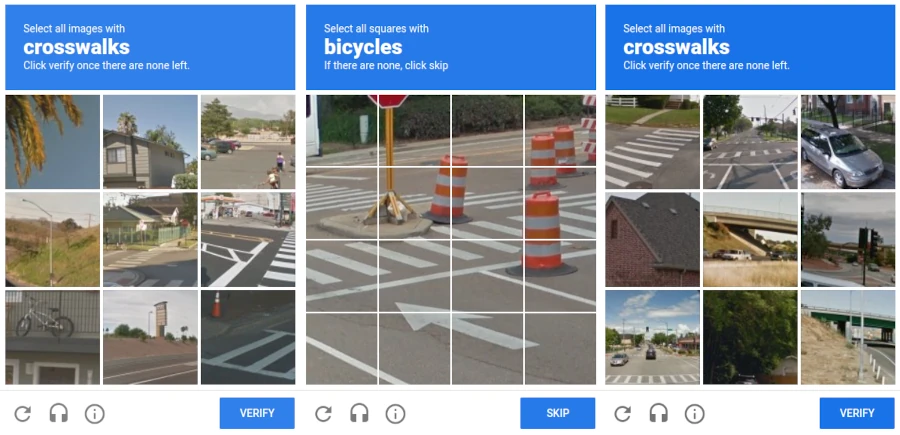

À noter : les CAPTCHA sont un bon exemple de cette logique. Quand vous sélectionnez les cases montrant des bus, des feux tricolores ou des passages piétons, vous aidez potentiellement une IA à apprendre à reconnaître ces objets. Ce micro-travail d’annotation, distribué à grande échelle, permet à des entreprises comme Google d’enrichir leurs bases d’entraînement pour la vision par ordinateur (Street View, Maps, etc.). C’est de l’apprentissage supervisé… à votre insu et quasiment du travail dissimulé.Concrètement, cela signifie que la machine passe par une phase d’entraînement où elle observe des paires « entrée / sortie ». À chaque fois qu’elle se trompe, elle ajuste progressivement ses paramètres internes (poids, coefficients) pour réduire l’erreur. Elle apprend à repérer les régularités qui relient les caractéristiques d’une entrée à la sortie attendue.

Par exemple, si l’on veut entraîner une IA à reconnaître des animaux sur des photos, on lui fournit des milliers d’images accompagnées de leur étiquette : « chat », « chien », « cheval »… L’IA apprend à associer certains motifs visuels à chaque classe. Si elle voit ensuite une image qu’elle n’a jamais rencontrée, elle pourra prédire, avec un certain degré de confiance, l’étiquette la plus probable.

Ce processus demande non seulement des données en grande quantité, mais aussi bien annotées. Si les étiquettes sont inexactes ou incohérentes, l’IA apprendra de travers. C’est pourquoi l’apprentissage supervisé nécessite une phase préalable de préparation et de validation humaine des données d’entraînement.

Exemples d’usages :

Cet apprentissage est le plus courant en entreprise car il est relativement contrôlable. Mais il demande beaucoup de données labellisées, ce qui peut être coûteux et long à constituer.

- Reconnaissance d’image (photo de chat ou de chien)

- Classification de mails (spam ou non-spam)

- Prévision de la demande en fonction de données passées

L’apprentissage non supervisé : chercher des structures cachées

Ici, on ne fournit pas de réponses. La machine reçoit des données brutes, et cherche à découvrir par elle-même des regroupements, des récurrences, des structures internes.

L’un des exemples classiques est le clustering (ou regroupement) : l’algorithme explore les similarités entre les données et les organise en groupes selon des critères implicites. Dans la segmentation marketing, par exemple, cela permet d’identifier des profils de clients aux comportements similaires sans avoir à prédéfinir ces profils.

Un autre exemple est la réduction de dimensionnalité : quand on dispose de données très complexes (par exemple des textes ou des images), l’apprentissage non supervisé permet de simplifier ces données tout en conservant leur structure essentielle. Cela facilite ensuite d’autres analyses ou visualisations.

Les méthodes d’analyse de sentiment dans les textes utilisent aussi des techniques non supervisées, en identifiant les mots et les expressions qui coexistent régulièrement dans un contexte donné, sans avoir à spécifier manuellement ce qu’est un “avis positif” ou “négatif”.

Exemples :

- Segmentation de clients selon leurs comportements d’achat

- Analyse de sentiments dans des corpus de texte

- Compression de données ou détection de similarités

- Recommandation de produits ou contenus similaires

Ce type d’apprentissage est exploratoire, utile pour générer des hypothèses, détecter des anomalies, ou préparer des données en amont d’un apprentissage supervisé. Il est généralement moins précis car il n’a pas de “vérité” à apprendre, mais il peut révéler des structures cachées inattendues.

L’apprentissage par renforcement : essayer, se tromper, recommencer

Inspiré du dressage animal, ce modèle fonctionne sur le principe de la récompense : l’IA agit dans un environnement, reçoit une récompense ou une punition, et ajuste son comportement en conséquence.

Ce type d’apprentissage repose sur une logique d’essai-erreur à grande échelle, parfois pendant des milliers ou des millions d’itérations. Il est particulièrement adapté aux environnements où les règles ne sont pas fixes ou totalement connues à l’avance, et où les décisions successives ont un impact sur le résultat global.

L’apprentissage par renforcement est-il “humain” ? On entend souvent que l’apprentissage par renforcement se rapproche de l’apprentissage humain. C’est vrai… en partie. C’est vrai qu’il repose sur une logique d’essai-erreur, comme les apprentissages précoces chez l’enfant. Il apprend de ses actions passées et ajuste son comportement. Il construit une stratégie dynamique, tenant compte du temps et des séquences de décision. Mais … L’IA n’a pas de conscience, de volonté ou d’émotion : elle optimise, mais sans comprendre, elle ne généralise pas de manière sémantique ou analogique, elle ne réfléchit pas sur elle-même, ne peut pas expliquer ce qu’elle fait, elle n’apprend pas par imitation ni par transmission sociale. En résumé : c’est une simulation partielle d’un comportement adaptatif, mais sans les ressorts cognitifs profonds de l’apprentissage humain. Une métaphore utile, mais à manier avec précaution.L’agent IA construit une « politique » d’action, c’est-à-dire une stratégie optimale en fonction de l’état de l’environnement dans lequel il évolue. Cette approche est très utilisée dans les jeux (où la simulation est facile), mais également dans des applications industrielles, logistiques ou robotiques où les environnements peuvent être modélisés.

Plus précisément, l’IA prend une décision à un instant donné (par exemple, déplacer un pion vers la droite), observe l’effet de cette action, puis actualise sa stratégie en fonction du « signal de retour » qu’elle reçoit. Ce signal peut être une note positive (gain de points, victoire, optimisation) ou négative (échec, perte de temps, blocage). L’IA apprend donc en explorant différentes actions et en identifiant celles qui maximisent la récompense cumulée à long terme.

Exemples :

- Jeux vidéo (l’IA apprend à gagner par essais/erreurs)

- Robots autonomes en environnement physique

- Optimisation de parcours logistiques ou stratégies de trading

Ce type d’apprentissage est complexe à mettre en œuvre mais redoutablement efficace dans des environnements bien simulés.

Ce que “apprendre” veut dire pour une machine (et ce que ça ne veut pas dire)

Lorsqu’on dit qu’une IA « apprend », on imagine facilement un processus analogue à celui d’un humain : comprendre, assimiler, interpréter. Or, l’apprentissage machine ne relève pas de la compréhension mais de l’ajustement statistique.

Concrètement, une IA ajuste des paramètres internes (poids, biais, coefficients…) pour que les sorties qu’elle produit se rapprochent le plus possible des bonnes réponses. Elle n’a pas conscience de ce qu’elle fait. Elle ne comprend pas les données. Elle optimise une fonction mathématique.

Cette fonction est souvent appelée fonction de coût ou fonction de perte. Elle mesure l’écart entre la prédiction du modèle et la réponse attendue. L’objectif de l’IA est de minimiser cette erreur, en adaptant ses paramètres à chaque itération. Ce processus d’optimisation s’effectue grâce à des algorithmes tels que la descente de gradient (gradient descent), une méthode qui permet d’ajuster progressivement les poids en suivant la pente de l’erreur.

Prenons une image d’un chat : l’IA ne « voit » pas un chat. Elle reçoit une matrice de valeurs numériques (les pixels), et apprend à repérer des motifs (bords, textures, couleurs) qui, statistiquement, sont associés à l’étiquette « chat » dans les exemples d’entraînement. Elle n’a ni sémantique, ni compréhension du concept de « chat ».

L’apprentissage est donc une affaire de corrélations. Si un motif est souvent associé à une réponse donnée, le modèle renforce cette association. Mais cela signifie aussi qu’il peut apprendre des corrélations erronées : par exemple, si tous les chats dans les images portent un collier rouge, l’IA risque d’associer « collier rouge » à « chat »… et de se tromper dès que ce détail disparaît.

C’est pour cela que l’on dit souvent que l’IA ne comprend pas, mais calcule des proximités statistiques. Elle généralise ce qu’elle a vu, sans pouvoir distinguer le sens, la causalité, ou la pertinence symbolique.

Dans des cas extrêmes, cette limite devient dangereuse. Les IA génératives peuvent produire des textes très convaincants… mais complètement faux, car elles n’ont aucun accès à la vérité. Elles « hallucinent » en produisant la suite la plus probable d’un point de vue linguistique, et non logique ou factuel.

C’est ce qui justifie les efforts croissants en IA explicable (XAI) et en audit de modèles. Comprendre ce que le modèle a appris, pourquoi il donne telle réponse, et dans quelle mesure il est biaisé, est devenu un enjeu critique dans les secteurs sensibles (santé, justice, finance).

Prenons une image d’un chat : l’IA ne « voit » pas un chat. Elle reçoit une grille de pixels et apprend à repérer des motifs qui, statistiquement, sont corrélés à l’étiquette « chat » dans les exemples d’entraînement. Elle n’a pas de représentation mentale, ni de modèle du monde.

Cela signifie qu’une IA peut parfaitement apprendre des choses fausses, si les données sont biaisées, incomplètes ou mal étiquetées. Elle peut aussi généraliser à tort, ou être incapable de s’adapter à un contexte nouveau. L’apprentissage est donc un processus fragile, entièrement dépendant de ce qu’on lui donne à « voir ».

Ce que cela change pour l’innovation en entreprise

Pour une entreprise, bien comprendre comment l’IA apprend permet de réduire les fantasmes, mais aussi d’en tirer un usage plus intelligent et stratégique.

D’abord, cela rappelle une vérité simple : l’IA n’est pas magique. Si vos données sont pauvres, désorganisées, biaisées ou trop peu nombreuses, votre IA ne fera pas de miracle. Il faut investir dans la qualité de la donnée, sa structuration, son annotation, sa représentativité.

Ensuite, cela signifie que l’IA peut devenir un véritable outil d’exploration : elle peut détecter des régularités, faire émerger des segments inattendus, générer de nouvelles hypothèses. Pour peu qu’on sache l’interpréter, elle peut nourrir la créativité autant que l’efficacité.

Enfin, cela pose une exigence nouvelle : celle de tester, observer, corriger. Une IA doit être entraînée, mais aussi surveillée, évaluée, confrontée à la réalité du terrain. Ce n’est pas un logiciel qu’on installe, mais un système vivant, qui interagit avec vos données, vos pratiques, vos décisions.

Ce que vous pouvez faire concrètement pour progresser

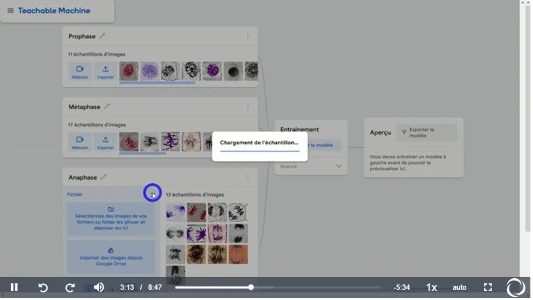

- Tester un apprentissage supervisé : sur Teachable Machine, entraînez un modèle à reconnaître vos expressions faciales ou des sons.

- Observer l’effet de vos données : créez deux modèles sur le même sujet, l’un avec des données bien étiquetées, l’autre avec des données bruitées. Comparez les performances.

- Explorer les biais possibles : lisez des exemples de dérives (ex. : IA de recrutement discriminante) pour comprendre ce que peut « apprendre » une machine mal encadrée.

- Lire des cas concrets : explorez les retours d’expérience d’entreprises ayant mis en place des IA de recommandation ou de prévision (notamment sur Hub France IA).

- Vous familiariser avec les notions clés : fonction de coût, surapprentissage, validation croisée, jeu de test… Ce sont des concepts simples mais essentiels pour dialoguer avec un prestataire IA.

À retenir

- Une IA n’apprend pas comme un humain : elle ajuste des paramètres pour optimiser une sortie, sans compréhension du sens.

- Il existe plusieurs types d’apprentissage : supervisé (avec exemples), non supervisé (sans réponse), par renforcement (essais/erreurs).

- L’apprentissage est totalement dépendant des données fournies : qualité, quantité, diversité.

- Une IA peut se tromper, apprendre un biais, ou être trop spécialisée : elle n’est ni magique ni neutre.

- Pour en tirer parti, il faut comprendre comment elle apprend — et accepter de la corriger, la surveiller, l’améliorer.

Testez vos connaissances

Partager avec les autres innovateurs

Dernières contributions aux forums

- Partage de prompts — Jean-Pierre Leac · L’IA en pratique · 1 novembre 2025 21:42Pour la prospection commerciale : Générer des idées de sujet pour un e-mail de prospection : "Je su…